Deepseek Strategies For The Entrepreneurially Challenged

페이지 정보

Otis Pokorny 작성일25-02-01 14:26본문

The DeepSeek app has surged on the app retailer charts, surpassing ChatGPT Monday, and it has been downloaded nearly 2 million times. Compared to Meta’s Llama3.1 (405 billion parameters used all of sudden), DeepSeek V3 is over 10 occasions extra environment friendly but performs better. "We estimate that compared to the very best international requirements, even the best domestic efforts face about a twofold gap in terms of mannequin structure and training dynamics," Wenfeng says. Any questions getting this mannequin working? Although the price-saving achievement could also be vital, the R1 mannequin is a ChatGPT competitor - a shopper-centered large-language mannequin. Made by Deepseker AI as an Opensource(MIT license) competitor to those industry giants. Its efficiency in benchmarks and third-get together evaluations positions it as a robust competitor to proprietary fashions. By nature, the broad accessibility of latest open supply AI models and permissiveness of their licensing means it is easier for other enterprising developers to take them and enhance upon them than with proprietary fashions. This mirrors how human experts typically reason: starting with broad intuitive leaps and steadily refining them into precise logical arguments. 먼저 기본적인 MoE (Mixture of Experts) 아키텍처를 생각해 보죠. 1: MoE (Mixture of Experts) 아키텍처란 무엇인가?

The DeepSeek app has surged on the app retailer charts, surpassing ChatGPT Monday, and it has been downloaded nearly 2 million times. Compared to Meta’s Llama3.1 (405 billion parameters used all of sudden), DeepSeek V3 is over 10 occasions extra environment friendly but performs better. "We estimate that compared to the very best international requirements, even the best domestic efforts face about a twofold gap in terms of mannequin structure and training dynamics," Wenfeng says. Any questions getting this mannequin working? Although the price-saving achievement could also be vital, the R1 mannequin is a ChatGPT competitor - a shopper-centered large-language mannequin. Made by Deepseker AI as an Opensource(MIT license) competitor to those industry giants. Its efficiency in benchmarks and third-get together evaluations positions it as a robust competitor to proprietary fashions. By nature, the broad accessibility of latest open supply AI models and permissiveness of their licensing means it is easier for other enterprising developers to take them and enhance upon them than with proprietary fashions. This mirrors how human experts typically reason: starting with broad intuitive leaps and steadily refining them into precise logical arguments. 먼저 기본적인 MoE (Mixture of Experts) 아키텍처를 생각해 보죠. 1: MoE (Mixture of Experts) 아키텍처란 무엇인가?

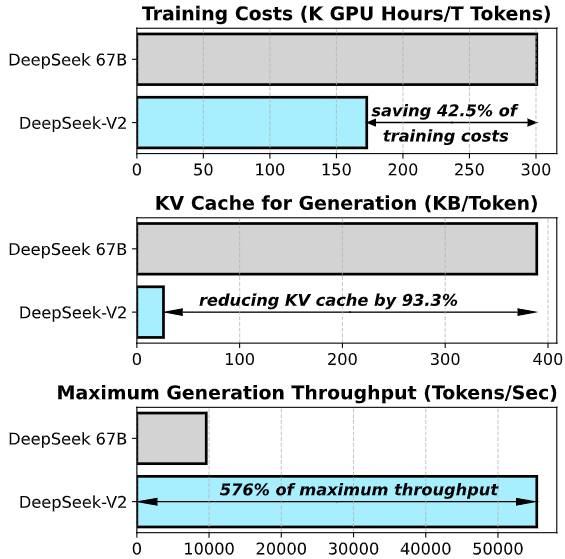

이런 두 가지의 기법을 기반으로, DeepSeekMoE는 모델의 효율성을 한층 개선, 특히 대규모의 데이터셋을 처리할 때 다른 MoE 모델보다도 더 좋은 성능을 달성할 수 있습니다. 그 이후 2024년 5월부터는 DeepSeek-V2와 DeepSeek-Coder-V2 모델의 개발, 성공적인 출시가 이어집니다. 자, 이렇게 창업한지 겨우 반년 남짓한 기간동안 스타트업 DeepSeek가 숨가쁘게 달려온 모델 개발, 출시, 개선의 역사(?)를 흝어봤는데요. 불과 두 달 만에, DeepSeek는 뭔가 새롭고 흥미로운 것을 들고 나오게 됩니다: 바로 2024년 1월, ديب سيك 고도화된 MoE (Mixture-of-Experts) 아키텍처를 앞세운 DeepSeekMoE와, 새로운 버전의 코딩 모델인 DeepSeek-Coder-v1.5 등 더욱 발전되었을 뿐 아니라 매우 효율적인 모델을 개발, 공개한 겁니다. 그리고 2024년 3월 말, DeepSeek는 비전 모델에 도전해서 고품질의 비전-언어 이해를 하는 모델 DeepSeek-VL을 출시했습니다. 그 결과, DeepSeek는 정해진 토큰 예산 안에서 고해상도 이미지 (1024X1024)를 효율적으로 처리하면서도 계산의 오버헤드를 낮게 유지할 수 있다는 걸 보여줬습니다 - 바로 DeepSeek가 해결하고자 했던, 계산 효율성 (Computational Efficiency) 문제를 성공적으로 극복했다는 의미죠. 이 Lean 4 환경에서 각종 정리의 증명을 하는데 사용할 수 있는 최신 오픈소스 모델이 DeepSeek-Prover-V1.5입니다.

이런 두 가지의 기법을 기반으로, DeepSeekMoE는 모델의 효율성을 한층 개선, 특히 대규모의 데이터셋을 처리할 때 다른 MoE 모델보다도 더 좋은 성능을 달성할 수 있습니다. 그 이후 2024년 5월부터는 DeepSeek-V2와 DeepSeek-Coder-V2 모델의 개발, 성공적인 출시가 이어집니다. 자, 이렇게 창업한지 겨우 반년 남짓한 기간동안 스타트업 DeepSeek가 숨가쁘게 달려온 모델 개발, 출시, 개선의 역사(?)를 흝어봤는데요. 불과 두 달 만에, DeepSeek는 뭔가 새롭고 흥미로운 것을 들고 나오게 됩니다: 바로 2024년 1월, ديب سيك 고도화된 MoE (Mixture-of-Experts) 아키텍처를 앞세운 DeepSeekMoE와, 새로운 버전의 코딩 모델인 DeepSeek-Coder-v1.5 등 더욱 발전되었을 뿐 아니라 매우 효율적인 모델을 개발, 공개한 겁니다. 그리고 2024년 3월 말, DeepSeek는 비전 모델에 도전해서 고품질의 비전-언어 이해를 하는 모델 DeepSeek-VL을 출시했습니다. 그 결과, DeepSeek는 정해진 토큰 예산 안에서 고해상도 이미지 (1024X1024)를 효율적으로 처리하면서도 계산의 오버헤드를 낮게 유지할 수 있다는 걸 보여줬습니다 - 바로 DeepSeek가 해결하고자 했던, 계산 효율성 (Computational Efficiency) 문제를 성공적으로 극복했다는 의미죠. 이 Lean 4 환경에서 각종 정리의 증명을 하는데 사용할 수 있는 최신 오픈소스 모델이 DeepSeek-Prover-V1.5입니다.

이제 이

댓글목록

등록된 댓글이 없습니다.